2025-09-30

Ende September 2025 stieß ich zufällig auf diesen Toot von autoweird.fm:

Wir reden in unserer neuen Folge über AI. […] Wir fühlen uns so wie damals, als wir Docker verschlafen haben! 💤

Ich habe den Toot im August passend dazu ebenfalls verschlafen, aber fairerweise muss ich sagen, ich bin auch kein Podcasthörer. Hier ist jedenfalls die Episode, falls jemand die nachhören möchte:

Folge 114: Wir haben die AI Zukunft verpennt

Benedikt und Holger, die ich beide sehr schätze, stellen korrekt fest, dass fast jede und jeder mittlerweile etwas zur künstlichen Intelligenz gesagt hat und jedwede Äußerung eigentlich schon fast überflüssig ist. Ergo, ich könnte es mir auch schenken, aber ich hatte zu viel Zeit, über obiges Zitat nachzudenken. Außerdem hilft es mir vielleicht, meine wachsende Angst, etwas zu verpassen, in den Griff zu bekommen (Neudeutsch FOMO, Fear of missing out).

Erst kurz zu Docker: Das initiale Docker Release erschien 2013, ein Jahr später im Oktober 2014 dann 1.0. Ich suchte zu dieser Zeit nach einer Möglichkeit, per Code unabhängige Testdatenbanken im Team bereitzustellen und fand die Technologie von Tag 1 an spannend, 2016 habe ich erste Vorträge darüber gehalten, viel später wurde ich Testcontainers-Community-Champion. Hätte ich diese Motivation nicht gehabt, wären Docker und Container durchaus eine Technologie gewesen, die ich hätte locker verschlafen können, zumindest bis ca. 2017/2018. Klar gab es Menschen, die darüber gesprochen haben, aber sie haben es nicht mit dem Sendungsbewusstsein eines Kultes in jeden Raum dieser Welt geschrien.

Hinsichtlich generativer, vortrainierte Transformer, vulgo GPTs, Co-Piloten, diverse Assistenten und Agenten und weitere KI-Auswüchse, klingt das alles ein bisschen anders:

Ich hab ChatGPT gefragt…!1elf!

Oder wenn ich mit Entwicklern spreche:

Ich habe heute mit Co-Pilot dieses und jenes gemacht…, Claude hat das für mich gemacht, und dann hat er noch Agenten genutzt…

Und das wären dann nur solche Fälle, in denen Menschen diese Technologie intrinsisch motiviert nutzen möchten und nicht alle möglichen und insbesondere unmöglichen Gelegenheiten, zu denen “irgendetwas mit Künstlicher Intelligenz” auf etwas drauf geklebt wurde, das ohne ✨ besser funktionieren würde. Verschlafen ist da schwierig.

Yeah, ich habe es verstanden, ich bin in diesem Fall der Boomer im Raum, und früher war alles besser. Allerdings gibt es tatsächlich Dinge, die in den letzten Jahren dank verbesserter Large Language Models (LLMs) auch für mich erheblich besser geworden sind, unter anderem:

Nicht besser geworden in meinen Augen ist Zugänglichkeit von Wissen. Ich kenne Menschen, die das Gegenteil behaupten und wenn ich mich einfach der Maschine ergebe, habe ich ganz schnell irgendwelche Ergebnisse, insofern haben diese Menschen recht. Denen möchte ich aber dringend den Post “The Scam Called “You Don’t Have to Remember Anything” an Herz legen. Er zitiert unter anderem Manfred Spitzer, aus “Digitale Demenz”:

Was man braucht, um im Netz fündig zu werden, ist eine solide Grundbildung und vor allem Vorwissen in dem Bereich, in dem sich die Suche bewegt.

Das Problem sind nicht nur schlechte Interfaces, sondern mangelnde Grundbildung. Durch ChatGPT vermittelte Informationen fühlen sich an, als könne jeder auf Augenhöhe zu allen Themen kommunizieren. Als Party-Halbwissen vollkommen ausreichend, im Alltag eher nicht.

Vor über 10 Jahren habe ich in einer Firma gearbeitet, die Vorhersagemodellen zur optimalen Strombeschaffung entwickelt hat. War das künstliche Intelligenz? Mitnichten, es war klassisches Machine-Learning. Aktuell arbeite ich im Datenbankumfeld. Meine Aufgaben haben meistens mit Abfragesprachen wie Cypher oder SQL zu tun. Selbstverständliche habe ich nicht nur vorhandene “Text to SQL” oder ähnliche Features von Produkten getestet, sondern auch eine “Text to Cypher” (eine Abfragesprache für Graphdatenbanken) Funktion entwickelt. Schema gestützt, mit Korrektur von generierten Abfragen. Auch das ist eine Übersetzung (siehe oben), auch das ist “irgendwas mit KI”. Funktioniert das gut? Ja, siehe oben.

Hingegen, Coding mit AI? Ich könnte, wenn ich wollte. Es ist eine Fähigkeit wie jede andere. Am Anfang meiner Karriere hatte ich keinerlei Ahnung von Java, heute bin ich Java Champion. Meine erste IDE war Oracle Forms, irgendwann musste ich mich Java IDEs beschäftigen. Früher hätte ich gesagt “Bah, mit Menschen arbeiten? Nur im Notfall” und habe zum Glück recht bald gelernt, dass das eine ganz dumme Idee ist und in der Regel sind gute Kommunikationsfähigen eines der wertvollsten Assets, auch und gerade in der IT-Branche, als Entwickler:in oder in anderen Rollen.

Warum will ich denn nicht? Meine Aufgabe ist nicht möglichst

viel Code in möglichst kurzer Zeit zu produzieren. Meine Aufgabe ist es,

Anforderungen zu verstehen, zu hinterfragen, umzusetzen und zu

dokumentieren und wenn es etwas Cooles ist, kann ich auch mal einen

Vortrag darüber halten. Um das mit guter Qualität zu können, muss ich

ein Thema durchdringen. Dazu lese ich, gerne und viel, am liebsten

primäre Quellen. Vorträge sind auch in Ordnung und es gibt tatsächlich

auch sehr gute Videos zu vielen Themen. Natürlich kann ich eine KI zur

Recherche benutzen, aber damit trainiere ich mir die Fähigkeit,

wichtiges vom unwichtigen zu unterscheiden, ab. Und ja, ich nutze den Google Konami-Code und die zusätzlichen

Queryparameter -ai und -ki. Ich möchte genau

das erreichen, was auf zettelkasten.de

beschrieben ist: Ein Thema durchdringen.

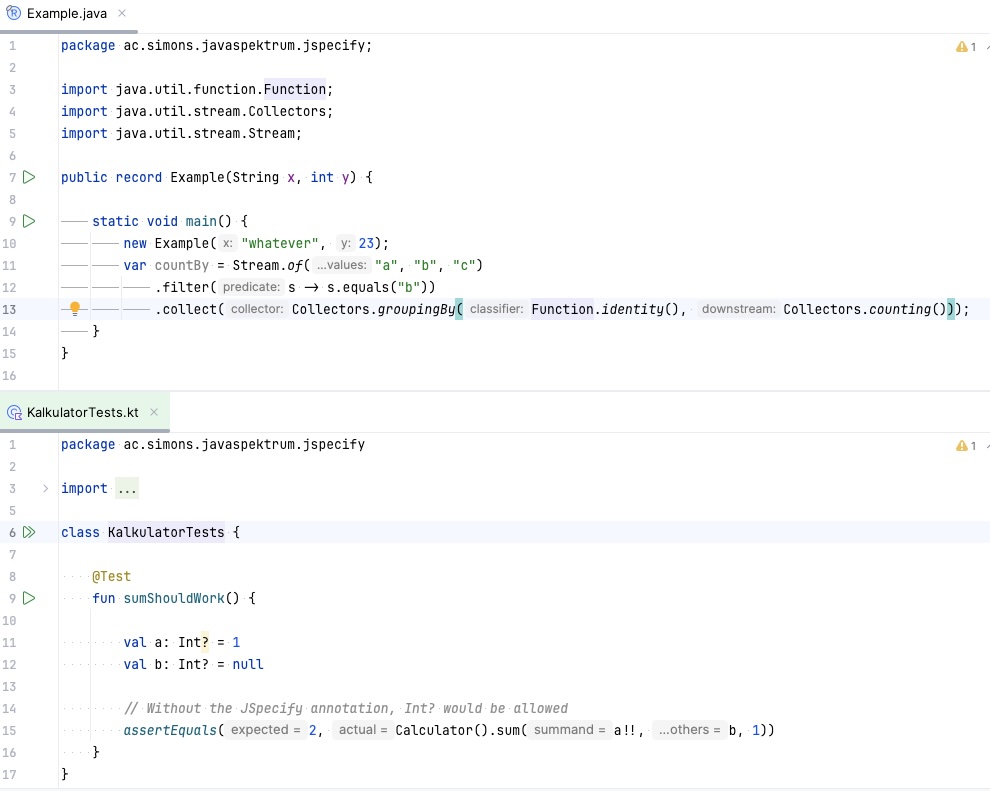

Warum dann nicht Co-Pilot zur Umsetzung verwenden? Die einfache Antwort wäre jetzt, weil mich schon folgender Screenshot nervt:

Nein, nicht weil es Java und Kotlin ist, sondern wegen der Inlays, die mir erklären, welcher Parameter wie heisst und gegebenenfalls noch den Typen anzeigen. Die Inlays erzeugen für mich extreme Unruhe und bringen mich aus dem Flow, ich habe das alles abgeschaltet. Einen Assistenten, der mir beliebigen Code in die aktuelle Klasse oder gar über das ganze Projekt kotzt, ist für mich die negative Steigerung davon. Und ja, mein Leben ist mir zu schade, seitenweise Repositoryanweisungen, am besten noch für mehrere Assistenten zu schreiben. Das ist kein Fortschritt. Was ich möchte und zum überwiegenden Teil auch habe:

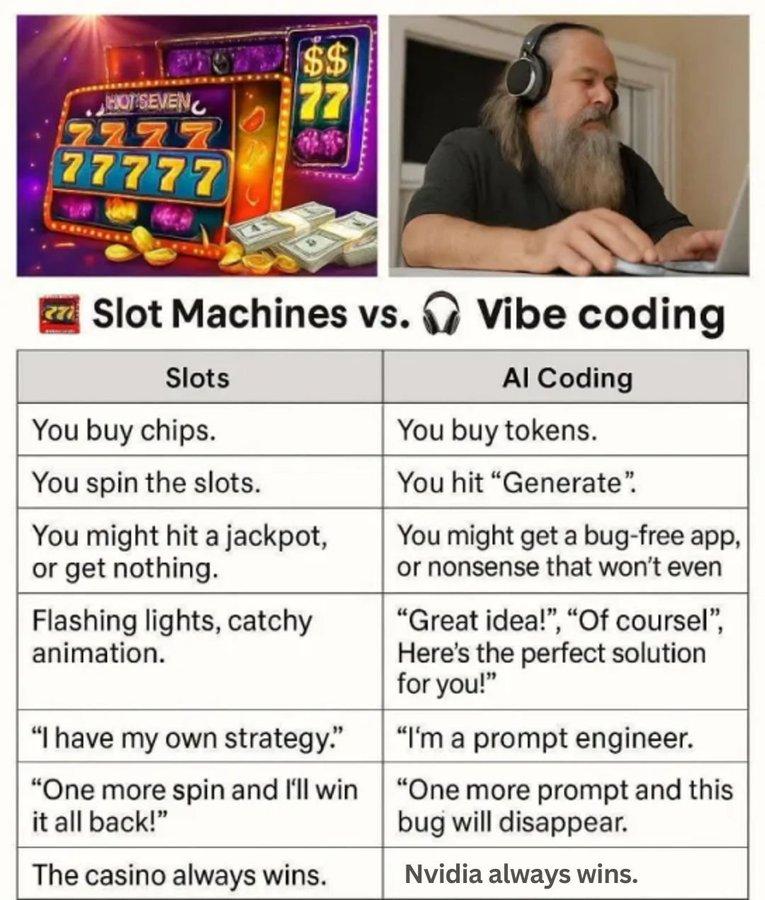

Sollte ich in meiner Freizeit noch Zeit mit Softwareentwicklung verbringen, kann ich mich entweder daran freuen, dass ich, während ich ein persönliches Problem mit Software löse, noch etwas lernen und einfach Dinge ausprobieren kann, oder halt so etwas machen:

Nachdem Prompt-Engineering und RAG durchgespielt wurden, ist “Agentic AI” jetzt groß in Mode. Wir haben das früher Pipelines oder Orchestrierung genannt, der Klebstoff ist jetzt ein LLM, das Dinge ausführt, sonst ändert sich nur überschaubar viel (außer vielleicht, das Menschen leichtsinniger geworden sind und beliebigen Tools Systemweiten Zugriff geben). Ich habe mal durch dieses Training geschaut und mir fallen folgende Punkte auf:

Requirements-Engineering hat ungeheuer viel mit Kommunikation zu tun. Vermutlich ist es hilfreich, unstrukturierte Ergebnisse Werkzeug gestützt zusammenzufassen. Ansonsten sehe ich da sehr viele Management- und Marketingaufgaben und das bringt mich zum letzten Punkt: Natürlich sind Machine-Learning-Modelle extrem hilfreich zur Erzeugung von Metriken jeder Art, sowie zur Generierung von OKRs, KPIs und Reviews. Auch viele Proof-of-Concepts der fast immer gleichen App werden sich wohl schnell generieren lassen. Möchten leitende Funktionen sich allerdings selber überflüssig machen? Wohl kaum. Und gerade deswegen werden diese in den Chor der KI-Kirche einstimmen und versuchen, den Einsatz von KI nach unten durchzusetzen, unabhängig davon, ob diese ihr Versprechen von mehr und auch besseren Ergebnissen hält. Menschen werden ihre Jobs verlieren und wenn die gewünschten Ergebnisse doch nicht eintreten, auch wieder neue finden, nur dann zu schlechteren Konditionen.

Separat betrachten würde ich den Block CI/CD:

Finde ich alles richtig, würde ich auch automatisieren wollen. Ob es dazu KI und Agenten braucht, will ich nicht beurteilen. Alles, was mit Generierung von Dingen zu tun hat, würde ich im besten Fall als Low-Code / No-Code Ansatz betrachten, der zugegebenermaßen je nach Domain gut bis sehr gut funktionieren kann.

Am Ende vom Tag geht es ums Geld, KI soll Dinge, hier Softwareentwicklung, günstiger machen. bain.com titelte Ende September 2025 folgendes:

$2 trillion in new revenue needed to fund AI’s scaling trend - Bain & Company’s 6th annual Global Technology Report

Und weiter:

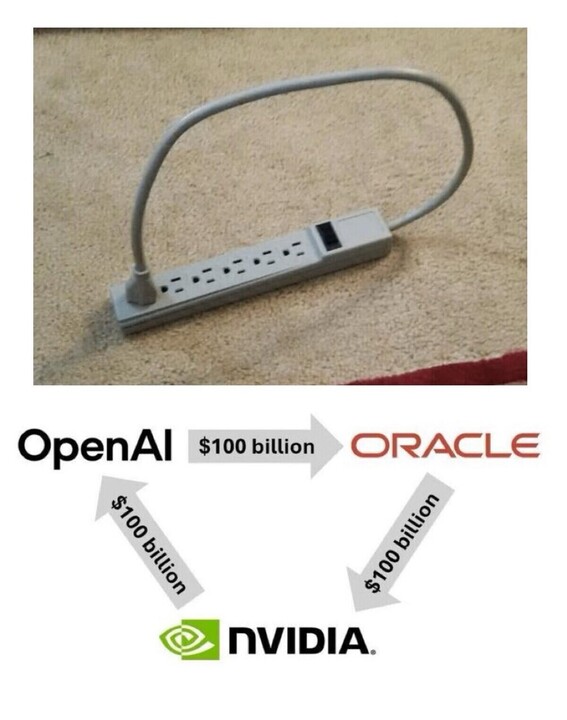

Even with AI-related savings, investors are still $800 billion short in annual revenue required to profitably fund the data centers of 2030

Woher sollen diese 800 Milliarden Dollar denn kommen? Durch Einsparungen in der Softwareentwicklung sicherlich nicht. Die Deutsche Bank(!) meldet übrigens ähnliche Bedenken an (hier ein deutscher Bericht). Sollte dieses Business-Perpetuum-Mobile etwa auch nicht ohne äußere Energiezufuhr funktionieren?

Nein, KI wird nicht verschlafen werden können. Der Hype wird lauter den je beschrieen und angefeuert werden, mehr ist besser, was inhaltlich produziert wird, spielt fast keine Rolle mehr, Hauptsache noch ein Abo verkauft. Sinnvolle Automatisierung oder nicht? Vollkommen egal. Wir werden uns in jeder Branche weiter und mehr unter Druck gesetzt fühlen, bis die Blase platzt. KI in der Softwareentwicklung wird nicht ohne dauerhaftes Abonnement und Trainieren von immer größeren Modellen funktionieren, Firmen werden früh genug dahinter kommen.

Allerdings hinterlässt jede Blase etwas und führt Veränderungen herbei, das war mit der dotcom-Blase und der Web 2.0-Blase nicht anders. Die KI-Blase wird Modelle hinterlassen, Rechenzentren, und fast perfekte Mustererkennung, insbesondere von Menschen und deren Verhalten, sowie automatische Einsortierung von Menschen nach beschreibbaren Metriken. Staaten, Sicherheitsministerien und staatsnahe Firmen werden bereitstehen, hier Geld zu investieren. Tante hat diesen Sachverhalt unter “These are not the same” schön zusammengefasst.

Larry Ellison, zweitreichste Mensch der Welt und Oracle CEO, einem Unternehmen, das die Öffentlichkeit gar nicht so im Bereich künstlicher Intelligenz vermutet, nimmt mittlerweile kein Blatt mehr vor den Mund:

“Citizens will be on their best behavior, because we’re constantly recording and reporting everything that is going on,” Ellison said in an hour-long Q&A during Oracle’s Financial Analyst Meeting last week.”

—Larry Ellison, September 2024 und wiederveröffentlicht 2025

Für mich ist das in Anblick aller weltweiten Krisen und Rechtsruck und der Entdemokratisierung etlicher Staaten kein schöner Ausblick; keine Kirche ohne Armageddon, das gilt auch für die KI-Kirche.

Als Ausblick empfehle ich noch folgende Bücher:

Die Autoren gehen im Detail auf durch künstliche Intelligenz verursache soziale Probleme der Gegenwart und Zukunft ein und sind hoffentlich hilfreich, einen anderen Standpunkt zu entwickeln, jenseits von “Oh cool, ich kann X mit Co-Pilot generieren” oder “Guck mal hier, das niedliche Mangabild, das ChatGPT für mich gemacht hat”.